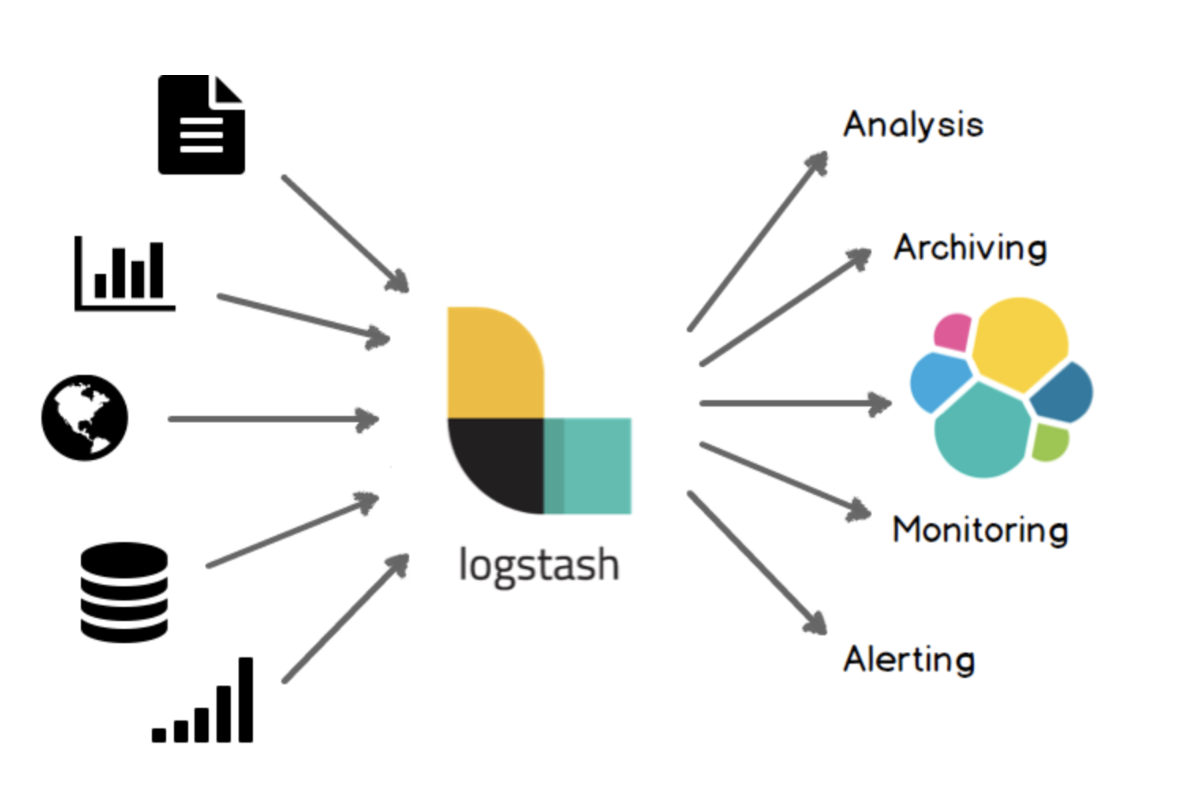

기본 이미지를 바탕으로 추가적인 명령어를 실행하여 원하는 이미지를 생성할 수 있다. [작업순서] Dockerfile 생성하기 docker build 명령어로 이미지 생성하기 Dockerfile 생성하기 본 logstash이미지에는 여러 플러그인들이 설치되어 있지만 원하는 플러그인이 없을 수도 있다. (ex: mongdb plugin) 이 경우 기본 이미지를 불러온 뒤 추가 명령어를 수행하여 mongodb 플러그인을 설치한 후 그것을 이미지화 시킬 수 있다. 파일이름은 반드시 Dockerfile로 해야한다. //logstash 기본 이미지 (Docker Hub 경로 입력..?) FROM logstash:7.17.0 //mongodb 플러그인 설치 커맨드 RUN logstash-plugin install l..